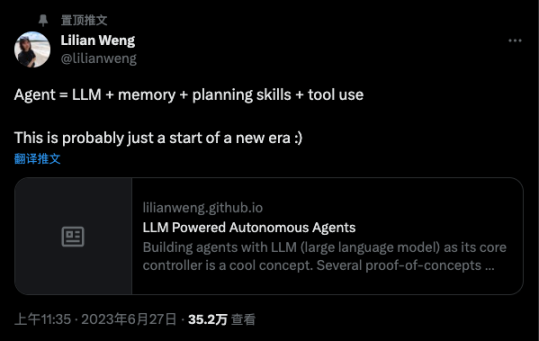

儘管在當前階段關於AGI 的技術爆發週期中,大型語言模型似乎是那個一直在舞台中央的主角,然而隨著OpenAI 的兩個關鍵的技術人物,Andrej Karpathy 和Lilian Weng 開始對外界釋放出一個信號,基於LLM 的AI Agents 是AGI 領域接下來重要的發展方向,使得很多原本嘲笑Auto-GPT 開發者,開始更多開始正視基於LLM 驅動的AI-Agents 系統。

正如Lilian Weng 在其萬字長文《LLM Powered Autonomous Agents》對Auto-GTP 的點評:

「AutoGPT 引起了許多關注,探索了使用LLM 作為主控制器構建自主代理的可能性。雖然由於自然語言界面存在相當多的可靠性問題,但它仍然是一個很酷的概念驗證演示。」

Auto-GPT 事實代表了LLM 可以發揮自動化的通用問題解決機器,這一敘事範式代表了AI-Agents 的未來發展方向。Lilian Weng 撰寫的《LLM Powered Autonomous Agents》是目前全世界對於什麼是AI-Agents 最好的論文綜述文章,結構化清晰明了的讓我們理解了什麼基於LLM 驅動的Agents。

事實上,經過這段時間對AI-Agents 的深度理解,以及對Lilian Weng 定義的AI-Agents 結構框架的研究思考,為了讓更多人理解Agents 的可能性(因為Lilian Weng 的原文還是具有相當高比例的技術解釋),在這里分享十篇具有較高可讀性的關於AI-Agents 論文,各位讀者可以下載PDF 通過Claude 2,或者Dify.ai 進行輔助閱讀。當然也可以加入社群,我會分享PDF 以及提示詞,讓AI 教你認識什麼是AI-Agents!這才是屬於超級個體的自我學習之路。

我的下一篇將圍繞《LLM Powered Autonomous Agents》進行深度解讀,並建立相關聯的知識體係與在知識庫,也將成為一個開源可索引的關於超級個體與AI-Agent 的高質量知識庫。

1. 構建有效的人工智能團隊:建立能夠補充多種專業能力的機器學習模型

論文標題:Forming Effective Human-AI Teams: Building Machine Learning Models that Complement the Capabilities of Multiple Expert

論文鏈接:https://arxiv.org/pdf/2206.07948.pdf

概述:機器學習(ML)模型越來越多地被用於需要與人類專家合作的應用領域。在這種情況下,當ML 模型難以預測某些實例時,將這些實例交給單個人類專家可能是有優勢的。雖然以前的研究集中在一個明確定義的人類專家場景上,但在許多真實情況下,可能會有多個具有不同能力的人類專家可供選擇。在這項工作中,我們提出了一種方法,通過訓練一個分類模型來補充多個人類專家的能力。通過將分類器與分配系統一起進行聯合訓練,分類器學會準確預測那些對人類專家來說很難的實例,而分配系統則學會將每個實例分配給最合適的團隊成員,可以是分類器或其中一個人類專家。我們在多個公共數據集上進行了實驗評估,包括使用「合成」專家標註的真實世界醫學數據集。我們的方法優於之前的工作,並且比最優秀的人類專家或分類器更準確。此外,它可以靈活地適應不同規模的團隊和不同水平的專家多樣性。

2. huggingGPT:利用HuggingFace 中的ChatGPT 及其相關模型解決AI 任務

論文標題:HuggingGPT: Solving AI Tasks with ChatGPT and its Friends in HuggingFace

論文鏈接:https://arxiv.org/pdf/2303.17580.pdf

概述:通過解決涉及不同領域和模態的複雜人工智能任務,是邁向人工通用智能的關鍵一步。雖然有許多適用於不同領域和模態的人工智能模型,但它們無法處理複雜的人工智能任務。考慮到大型語言模型(LLMs)在語言理解、生成、交互和推理方面表現出色,我們認為LLMs 可以充當控制器,管理現有的人工智能模型來解決複雜的人工智能任務,而語言可以成為通用接口來實現這一點。基於這一理念,我們提出了HuggingGPT,這是一個框架,利用LLMs(例如ChatGPT)將機器學習社區(例如Hugging Face)中的各種人工智能模型連接起來,以解決人工智能任務。具體而言,當接收到用戶請求時,我們使用ChatGPT 來進行任務規劃,根據Hugging Face 中提供的模型功能描述來選擇模型,然後使用選定的人工智能模型執行每個子任務,並根據執行結果總結回應。通過利用ChatGPT 強大的語言能力和Hugging Face 中豐富的人工智能模型,HuggingGPT 能夠涵蓋許多不同模態和領域的複雜人工智能任務,並在語言、視覺、語音和其他具有挑戰性的任務中取得令人印象深刻的成果,為邁向人工通用智能開闢了新的道路。

3. 人工智能心智理論:兩個人一起跳探索

論文標題:It Takes Two to Tango: Towards Theory of AI’s Mind

論文鏈接:https://arxiv.org/pdf/1704.00717.pdf

概述:心智理論(Theory of Mind)是將心智狀態(信念、意圖、知識、觀點等)歸因於他人,並認識到這些心智狀態可能與自己不同的能力。心智理論對於有效溝通和團隊展現更高集體績效至關重要。為了有效地利用人工智能(AI)的進步使我們的生活更加高效,人類和AI 需要在團隊中良好地合作。傳統上,研究更多地側重於使AI 更準確,並在較小程度上使其更好地理解人類的意圖、傾向、信仰和背景。後者涉及使AI 更像人類,並使其發展對我們心智的理論。在這項工作中,我們認為,為了使人類-AI 團隊有效,人類也必鬚髮展對AI 心智的理論(ToAIM)——了解其優勢、弱點、信念和特點。我們在視覺問答(VQA)領域內實現了這些想法。我們發現,僅使用少量的示例(50 個),普通人可以接受培訓,以更好地預測複雜VQA 模型的回應和潛在失敗。我們進一步評估了現有解釋(或可解釋性)模式在幫助人類建立對AI 心智的理論方面所起的作用。在最近的科學和普遍關注中,可解釋的AI 受到了相當大的關注。令人驚訝的是,我們發現,獲得模型的內部狀態——其對前k 個預測的信心、明確或隱含的注意力映射(突出顯示模型在回答有關圖像的問題時正在查看(和聆聽)的圖像區域和問題中的單詞)——並不能幫助人們更好地預測其行為。

4. MindCraft:基於心智模型的協作任務情境對話建模

論文標題:MindCraft: Theory of Mind Modeling for Situated Dialogue in Collaborative Tasks

論文鏈接:https://arxiv.org/pdf/2109.06275.pdf

概述:在人類世界中,將自主代理理想地融入其中意味著它們能夠按照人類的方式進行合作。特別是,在人類的協作和交流過程中,心智理論發揮著重要作用,有助於維持共同基礎。為了在情境交互中實現心智理論建模,我們引入了一個細粒度的數據集,記錄了由一對人類主體在Minecraft 虛擬三維方塊世界中執行的協作任務。該數據集提供了有關合作夥伴對世界和對彼此的信念的信息,為研究情境語言交流中的人類協作行為提供了豐富的機會。作為實現我們目標的第一步,即開發能夠推斷合作夥伴信念狀態的具身人工智能代理,我們建立了並展示了針對幾個心智理論任務的計算模型。

5. 大語言模型中發揮認知協同作用:通過多人格自我協作成為任務解決代理

論文標題:Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration

論文鏈接:https://arxiv.org/pdf/2307.05300.pdf

概述:人類智能依賴於認知協同的概念,在不同認知過程之間進行合作和信息整合,相比單獨的認知過程,能夠產生更優越的結果。儘管大型語言模型(LLMs)在作為通用任務解決代理方面表現出有希望的性能,但它們仍然在需要大量領域知識和復雜推理的任務中遇到困難。在這項工作中,我們提出了「Solo Performance Prompting」(SPP)的概念,它通過與多個人物進行多輪自我協作,將單個LLM 轉變為認知協同者。認知協同者指的是一種智能代理,它與多個思維合作,結合他們的個體優勢和知識,以增強複雜任務中的問題解決和整體性能。通過根據任務輸入動態地識別和模擬不同的人物,SPP 釋放了LLMs 中認知協同的潛力。我們發現,在LLMs 中分配多個細粒度的人物角色,相比於使用單個或固定數量的人物角色,能夠激發更好的問題解決能力。我們在三個具有挑戰性的任務上評估了SPP:創意性問答、Codenames 協作和邏輯格子謎題,涵蓋了知識密集型和推理密集型兩種類型。與之前僅增強LLMs 推理能力的作品(如Chain-of-Thought)不同,SPP 有效地激發了內部知識獲取能力,減少了幻覺,並保持了強大的推理能力。代碼、數據和提示信息可以在以下鏈接找到:https://github.com/MikeWangWZHL/Solo-Performance-Prompting.git。

6. 人工智能與人類的共生:現有方法綜述

論文標題:Human-AI Symbiosis: A Survey of Current Approaches

論文鏈接:https://arxiv.org/pdf/2103.09990.pdf

概述:本論文旨在提供人工智能與人類協作中不同研究方向的全面概述。通過突出人工智能與人類團隊的各個方面,例如互補流程、任務視野、模型表示、知識水平和團隊目標,我們根據這些維度對最近的研究進行分類。我們希望這份調查能夠更清晰地連接人工智能與人類團隊中的研究工作,並為這一領域的新研究人員提供指導。

7. 自省提示:用於上下文決策的大型語言模型

論文標題:Introspective Tips: Large Language Model for In-Context Decision Making

論文鏈接:https://arxiv.org/pdf/2305.11598.pdf

概述:大型語言模型(LLMs)的出現對自然語言處理產生了重大影響,在各種任務中展現出卓越的結果。在本研究中,我們採用「自省提示」來幫助LLMs 在自我優化決策方面取得進展。通過自省地檢查軌跡,LLMs 通過生成簡潔而有價值的提示來優化其策略。我們的方法通過考慮三種關鍵情景,即從代理的過去經驗中學習、整合專家示範和在不同遊戲中進行泛化,來提高代理在少樣本和零樣本學習情況下的性能。重要的是,我們在不微調LLMs 參數的情況下實現了這些改進;相反,我們調整提示以從上述三種情況中進行洞察力的泛化。我們的框架不僅支持而且強調在上下文決策中使用LLMs 的優勢。在涉及TextWorld 中超過100 個遊戲的實驗中,我們的方法展現出優越的性能。

8. 面向決策的人工智能協作對話

論文標題:Decision-Oriented Dialogue for Human-AI Collaboration

論文鏈接:https://arxiv.org/pdf/2305.20076.pdf

概述:我們描述了一類稱為「面向決策對話」的任務,其中AI 助手必須通過自然語言與一個或多個人類合作,幫助他們做出複雜的決策。我們形式化了三個領域,其中用戶面臨日常決策:(1) 選擇會議論文的評審人員分配,(2) 規劃城市中的多步行程,以及(3) 為一組朋友協商旅行計劃。在每種情況下,AI 助手和用戶擁有各自不同的能力,他們必須結合起來得出最佳決策:助手可以訪問和處理大量信息,而用戶擁有系統外的偏好和限制。對於每個任務,我們構建了一個對話環境,代理根據他們達成的最終決策的質量獲得獎勵。利用這些環境,我們收集了由人類扮演助手角色的人與人之間的對話。為了比較當前AI 助手在這些情況下的通信方式,我們提供了使用大型語言模型進行自我對話的基準模型。最後,我們強調了決策導向對話中模型面臨的一系列挑戰,包括高效的溝通、推理和優化,並將我們的環境發佈為未來建模工作的測試平台。

9. 生成代理:人類行為的交互模擬體

論文標題:Generative Agents: Interactive Simulacra of Human Behavior

論文鏈接:https://arxiv.org/pdf/2304.03442.pdf

概述:可信的人類行為代理可以為交互式應用提供支持,從沉浸式環境到人際交流排練空間再到原型工具。在本文中,我們引入生成性代理——模擬可信人類行為的計算軟件代理。生成性代理醒來、做早餐、上班;藝術家繪畫,作家寫作;他們形成意見,注意彼此,並發起對話;他們回憶和反思過去的日子,規劃下一天的計劃。為了實現生成性代理,我們描述了一種架構,將大型語言模型擴展為使用自然語言存儲代理的完整經歷記錄,隨時間將這些記憶綜合為更高層次的反思,並動態地檢索它們來規劃行為。我們將生成性代理實例化,以填充受《模擬人生》啟發的交互式沙盒環境,最終用戶可以使用自然語言與25 個代理在小鎮上進行互動。在評估中,這些生成性代理產生了可信的個體和緊急的社會行為:例如,僅從用戶指定一個代理想要舉辦情人節派對的概念開始,代理會在接下來的兩天自動傳播派對的邀請,結識新朋友,並相互邀請出席派對,並協調在正確的時間一起出現在派對上。通過消融實驗,我們證明了我們代理架構的觀察、規劃和反思組件對代理行為的可信度都起到了關鍵作用。通過將大型語言模型與計算性交互代理融合,這項工作介紹了實現可信人類行為模擬的架構和交互模式。

10. 人工道德代理的最低可解釋性要求

論文標題:Minimum Levels of Interpretability for Artificial Moral Agents

論文鏈接:https://arxiv.org/pdf/2307.00660.pdf

概述:隨著人工智能(AI)模型的不斷擴大,它們正在變得更加強大,並融入各種形式的決策系統中。對於參與道德決策的模型,也稱為人工道德代理(AMA),解釋性提供了一種理解和信任代理內部推理機制的方式,以實現有效使用和錯誤修正。在本文中,我們概述了這個快速發展的AI 解釋性子領域,引入了「最低可解釋性水平」(MLI)的概念,並針對不同類型的代理推薦了一個MLI,以幫助它們在現實世界的環境中安全部署。

縮寫詞:AI = 人工智能,AMA = 人工道德代理,BU = 自底向上,GPT = 生成式預訓練轉換器,IML = 可解釋的機器學習(或解釋性),LLM = 大型語言模型,MDM = 道德決策,ML = 機器學習,MLI = 最低可解釋性水平,TD = 自頂向下。